Wojciech Dudkiewicz: Rozwój sztucznej inteligencji (AI) wzbudza bardziej entuzjazm niż obawy – wynika z badania World Trend Index. Duża część pracowników na świecie obawia się, że AI zastąpi ich w pracy, ale znacznie więcej z nich chce przerzucić na sztuczną inteligencję pewną ilość zadań. Są nieświadomi zagrożeń?

Prof. Andrzej Zybertowicz: Przyglądamy się rzeczywistości na ogół punktowo. Każdy z nas orientuje się w świecie w zależności od wykonywanych zadań – zawodowych i rodzinnych. Drwal np. rozumie, jak rosną drzewa i które z nich nadają się do wycinki, nie musi natomiast pojmować procesu sterowania płynnością ruchu w dużym mieście. Wybitny fizyk budujący wyrafinowane modele kosmologiczne może być naiwny, jeśli chodzi o flirtowanie nastolatków. Ludzie oceniają znaczenie innowacji w ramach swoich horyzontów poznawczych. Mało kto, z wyjątkiem analityków i badaczy przyglądających się systemom społecznym, na co dzień posługuje się pojęciem nieplanowanych, trudno rozpoznawalnych konsekwencji jakiegoś działania. Innowacja, która w krótkim czasie może przynosić korzyści, po upowszechnieniu się może powodować mnóstwo złych konsekwencji.

Czy mógłby Pan Profesor podać jakiś przykład?

Dla wielu Amerykanów prawo do posiadania broni, wpisane w drugą poprawkę do konstytucji, jest czymś bardzo ważnym. Ale w żadnym innym kraju nie powtarzają się rzezie w szkołach, gdy nastolatek przychodzi do szkoły z karabinem i zabija swoich kolegów. To jeden z dzisiejszych skutków upowszechnienia się innowacji prawnej, którą był masowy dostęp do broni... Moim zdaniem, nawet gdybyśmy mieli do czynienia tylko z technologiami, których nie można stosować do złych celów, to w ostatnim czasie w systemy społeczne jednocześnie wprowadzanych jest za dużo innowacji. Nawet jeśli każda z nich, postrzegana osobno, przynosiłaby same dobre efekty, to nakładanie się ich na siebie rodzi dezorientację. Gdy tempo zmian przekracza zdolność objęcia ich ludzkimi umysłami oraz możliwości regulacyjne organizmów państwowych – rodzi się chaos.

Pomóż w rozwoju naszego portalu

Reklama

Często, nawet gdy rozumiemy zagrożenie, myślimy: to kwestia dalekiej przyszłości, mnie to nie dotyczy...

Taka ucieczka od odpowiedzialności jest niebezpieczna, tym bardziej że rośnie odsetek młodych ludzi, którzy programowo wyrzekają się posiadania dzieci. Jest cała grupa mediów, firm i fundacji, które lansując postawy konsumpcjonizmu i hiperindywidualizmu, ich w tym wzmacniają. A to musi się przekładać na brak odpowiedzialności za przyszłość. Jeśli ktoś nie ma dzieci i nie spodziewa się mieć wnuków, to łatwiej jest nim manipulować – nasilając konsumpcjonizm – by nie przejmował się przyszłością. Stąd głosy: jeśli jakaś technologia sztucznej inteligencji, jak ChatGPT, jest dziś atrakcyjna, to się nią bawmy. Tym bardziej kiedy pomoże rozwiązać jakiś problem, zrobi coś szybciej od człowieka, np. przygotuje ilustrację graficzną, napisze tekst itp.

...nawet wiersz czy poemat.

I masę innych rzeczy, i to powyżej jakości dostępnej większości ludzi. Systemy AI dostarczają dzieł plastycznych, które warsztatowo przekraczają możliwości plastyków zatrudnionych w korporacjach. Po „wytrenowaniu” AI na wielkiej części dorobku ludzkości może ona od razu działać na poziomie mistrzowskim.

Gdy ktoś widzi fajną zabawkę, która pomaga mu zrobić coś, co kiedyś było dlań niedostępne, zyskuje poczucie podmiotowości: stworzyłem coś. Nie dostrzega tego, że gdy taka zabawka się rozpowszechni, to przyniesie szkody także jemu. Ale jeśli te szkody na poziomie cywilizacyjnym ujawnią się, kiedy nie będzie go już wśród nas – nie musi się o to troszczyć. Odbieranie ludziom odpowiedzialności za młode pokolenie to kolejny degradacyjny trend cywilizacyjny po odebraniu ludziom Boga przez europejskie oświecenie. Nie ma Boga, no dobrze, ale mam dzieci, czuję się za nie odpowiedzialny, warto z mojego majątku coś im zostawić. Jeśli programowo nie chcę mieć dzieci, to po „śmierci Boga” następuje kolejna faza – „śmierć” odpowiedzialności. I przyczyniają się do tego nowe technologie cyfrowe. To jedna z perspektyw, która powinna być rozważana przez wszystkich, także przez Kościół.

Reklama

Czy Kościół dostrzega problem sztucznej inteligencji?

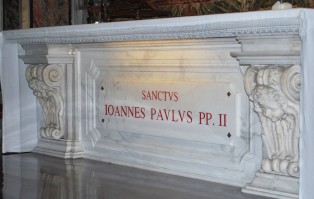

Byłem niedawno w Watykanie, rozmawiałem z polskimi duchownymi, którzy tam pracują, i wspólnie doszliśmy do wniosku, że istnieje potrzeba, żeby w tej kwestii mocno zabrzmiał głos papieża. Naprawdę warto ogłosić encyklikę w tej sprawie. Jeden z księży zaproponował tytuł, który po polsku brzmiałby: „Jesteśmy spóźnieni”. My – ludzie żyjący w przekonaniu, że istnieje wymiar metafizyczny – jesteśmy spóźnieni w przestrzeganiu nie tylko wiernych, ale także niewierzących, dla których głos Ojca Świętego jest ważny jako sygnał wrażliwości i głos wielkiej wspólnoty.

Ale to nie opóźnienie miałoby być istotą tego ostrzeżenia? Kościelne młyny mielą powoli...

Zbyt wolno, a technologia pędzi. Ciekawy byłby też w sprawie sztucznej inteligencji głos wybitnych teologów, marzyłyby mi się konferencje przygotowywane przez episkopaty różnych krajów. Przypominają się dyskusje wybitnych umysłów, które w Castel Gandolfo organizował Jan Paweł II...

Zbyt późno, tak uważam, doszło np. do zrozumienia w Watykanie sytuacji na Ukrainie. Spójrzmy teraz na zagrożenia AI w długofalowej perspektywie cywilizacyjnej: czyż to, co sztuczna inteligencja może uczynić ze światem ludzkim, nie jest równie przerażające jak zniszczenia i okrucieństwo siane przez wojnę Putina? A może, w tej właśnie optyce cywilizacyjnej, AI jest jeszcze większym zagrożeniem dla ludzkości?

Reklama

Mocna ocena.

Uzasadnię ją. Eksperci mówią, że nawet gdyby doszło do wojny między Rosją i USA, takiej, do której włączyłyby się Chiny, do pełnowymiarowej wymiany nuklearnych uderzeń – ludzkość i tak przetrwa. Cywilizacja mogłaby zostać zdruzgotana, ale setki milionów ludzi przetrwają. I zachowają wiedzę, na czym polegają cywilizacja naukowo-techniczna, prawa człowieka i instytucje ich ochrony. Owszem, spadłby poziom życia, ale fundamenty cywilizacyjne przetrwałyby jako podstawa do odbudowy.

A w przypadku sztucznej inteligencji?

Gdyby rozwijała się w kierunku tzw. silnej superinteligencji, jako ludzie możemy stać się dla niej mało ważni, niemal niedostrzegalni. Są różne scenariusze. W tym taki: AI może być tak zainteresowana eksploracją innych galaktyk – że aby zbudować sobie służące temu nowe technologie, zużyłaby wszystkie zasoby energetyczne Ziemi. Z opłakanymi skutkami dla nas. AI nie musi mieć wobec nas żadnych złych intencji, wystarczy, że znajdziemy się na marginesie jej zainteresowań. Eksplozja sztucznej superinteligencji może wywołać skutki przekraczające siłę rażenia wszystkich bomb jądrowych, które są dziś na Ziemi.

Ale to, na szczęście, tylko perspektywa pewnej hipotezy.

Oczywiście, że tak. Nie ma dziś żadnej teorii naukowej, z której by wynikało, że tak musi się to skończyć. Nie ma też żadnej poważnej teorii naukowej, która by mówiła, że agresja Rosji na Ukrainę musi się przerodzić w wojnę jądrową. Ale nie wykluczamy tego.

W książce Cyber kontra real. Cywilizacja w techno-pułapce pisze Pan Profesor, że żyjemy w momencie, w którym można jeszcze odzyskać przewagę nad technologią. Apel o moratorium w pracach nad AI podpisało ponad 30 tys. specjalistów. Jeden z pionierów AI zaczął ostrzegać przed ryzykiem, jakie wiąże się z tą technologią, a Unia Europejska próbuje regulacji. To dużo za mało. Czy jest szansa na cofnięcie się, wprowadzenie regulacji ograniczającej tę technologię?

O potrzebie moratorium technologicznego mówię co najmniej od 2015 r., od wydania razem z zespołem książki Samobójstwo Oświecenia?. Choć, moim zdaniem, postulat moratorium jest logicznie uzasadniony, to obawiam się, że nie zostanie wprowadzony z powodu czysto racjonalnego postępowania – systemy społeczne tak, niestety, nie działają. Może natomiast zostać wcielony w życie, gdy ludzkość dotknie – tak to określmy – katastrofa średniego kalibru.

Reklama

To znaczy?

Na tyle słaba, by ramy obecnego ładu globalnego przetrwały, ale na tyle dramatyczna, by szok nią wywołany uświadomił konieczność podjęcia nadzwyczajnych działań naprawczych. Natura systemów decyzyjnych w dzisiejszym świecie jest taka, że bez potężnego wstrząsu opinii publicznej nie będzie gotowości do radykalnych, ale niezbędnych działań. Wstrząsy, które nasza cywilizacja przeżyła w ostatnich latach: kryzys finansowy w 2008 r., pandemia COVID-19, tysiące ofiar i ludobójstwo na Ukrainie, nie okazały się wystarczająco przemawiającymi do wyobraźni dramatami, żeby się ogarnięto. Cała nadzieja w tym, że stanie się to, zanim sztuczna inteligencja nabierze pełnej mocy. Zakładam, że nie doszliśmy jeszcze, na szczęście, do punktu krytycznego, gdy uruchomią się procesy samodoskonalenia się AI, nad którymi nie będziemy mieli już żadnej kontroli.

Ci, którzy prowadzą i finansują badania nad sztuczną inteligencją, którzy je rozbujali do obecnego stanu, mają na uwadze pieniądze i władzę. Czy coś jeszcze?

Jest coś, co trzeba dodać w przypadku Geoffreya Hintona, jednego z guru środowiska sztucznej inteligencji. Odchodząc niedawno z Google’a, Hinton powiedział, że jakaś jego część żałuje, iż przyczynił się do rozwoju AI. W 2015 r. na pytanie, że skoro widzi zagrożenia, iż ludzie o skłonnościach terrorystycznych mogliby nadużywać AI, to czemu nad tym dalej pracuje, odpowiedział, że smak odkrycia jest taki słodki... Jest zatem trzecia motywacja, poza władzą i pieniędzmi – fascynacja własnym sukcesem poznawczym, przygodą przy rozwiązywaniu trudnych problemów. A gdy taka przygoda jest ważniejsza niż zobowiązania moralne, to mamy kolejny zły znak czasu.

Reklama

Na jesień zapowiadana jest premiera nowej, piątej wersji ChatGPT – narzędzia AI, które według ekspertów może osiągnąć poziom ludzkiej inteligencji i rozumienia. Czy to początek wymykania się sztucznej inteligencji spod kontroli?

Nie wiadomo dokładnie, czy akurat tego można się spodziewać, ale szybki rozwój sztucznej inteligencji wciąż zaskakuje nawet samych jej twórców. Zwrócę uwagę na coś innego. Pytanie: na jakim etapie należy sztuczną inteligencję uznać za odrębny podmiot, za „istotę zdolną do przeżywania cierpienia”? A jeśli sztuczna inteligencja będzie symulowała cierpienie, żeby wywołać zamieszanie albo empatię? Około roku temu inż. Blake Lemoine z Google’a powiedział publicznie, że program sztucznej konwersacji LaMDA, który testował, jest „świadomą istotą, której pragnienia należy uszanować”.

Za to został z Google’a zwolniony...

Tak. A chodziło o program słabszy od ChatGPT. Wyobrażam sobie, że gdy jakaś kolejna wersja będzie wyraźnie lepsza, pojawią się ruchy społeczne na rzecz przyznania danemu systemowi AI praw ludzkich. Są już przecież ruchy tych, którzy uważają, że trzeba odrębne prawa przyznawać nie tylko zwierzętom, ale i roślinom. Patrzę na to wszystko pod kątem zwiększania zamętu w już i tak zdestabilizowanym życiu społecznym. Nie próbuje się całościowo podejść do poważnych problemów, przed którymi stoi ludzkość: strukturalnie zatrutej infosfery i rosnącego oceanu dezinformacji, epidemii samotności i depresji, głębokiej dezorientacji młodego pokolenia w obliczu wyzwań ich życia, ogromnych nierówności społecznych – wielkich fortun ludzi o zasobach, których nie wydadzą do końca życia, a działają poza demokratyczną kontrolą itd. Zamiast podchodzić do takich problemów całościowo, tysiące wybitnych umysłów próbuje tworzyć kolejne „przełomowe” innowacje, by zdobyć sławę i miliardy, przy okazji generując nowe strumienie problemów. Tak widzę główne zagrożenie przyniesione przez rewolucję cyfrową, której AI jest – oby nie cierniowym – ukoronowaniem. Już dawno wypowiedziano tezę, że jak ruszy superinteligencja, to będzie to ostatni wynalazek człowieka.

Przyzna Pan Profesor, że to ponura, dramatyczna wizja...

To jeszcze dopowiem. W ostatnich kilkunastu latach zbliżają się do siebie dwie krzywe. Jedna z nich pokazuje proces zwiększania się sprawności wykonywania zadań przez AI. Krzywa idzie wyraźnie pod górę, choć wcześniej miała przestoje. Druga krzywa, wyznaczona przez rewolucję cyfrową, a zwłaszcza media społecznościowe, obrazuje degradację poznawczą człowieka. Te krzywe jeszcze się nie spotkały, ale gdy do tego dojdzie, to będzie po nas. Może sztuczna inteligencja nas nie zlikwiduje, ale najpewniej utracimy kontrolę nad swoją cywilizacją. Żadna dyskusja o wartościach, na bazie których warto świat zmieniać, nie będzie miała sensu, bo to nie my będziemy dysponować kluczowymi zasobami.

Zdjęcie na okładce zostało wygenerowane przez sztuczną inteligencję

Prof. Andrzej Zybertowicz socjolog z Uniwersytetu Mikołaja Kopernika w Toruniu, kierownik Ośrodka Studiów nad Wyzwaniami Cywilizacyjnymi Akademii Sztuki Wojennej, doradca prezydenta RP i szefa Biura Bezpieczeństwa Narodowego.